- Home

- Categorie

- Digital Marketing

- SEO

- Test SEO: rimozione tramite X-Robots-Tag di una pagina bloccata da robots.txt

-

@kal Grazie per il test anche se era piuttosto tautologico il rispetto di Google per il robots.txt (vediamo anche nostra recente discussione) e soprattutto la necessità di Googlebot di leggere una risorsa, anche solo nel suo header.

Che poi - non vorrei ricordare male - da qualche parte avevo letto un commento di qualcuno di Google in cui diceva che comunque gli x-robots-tag, anche se già presenti nell'header, venivano considerati in fase di analisi della pagina e non del protocollo (come potrebbe essere uno status code).Ne vien da se - ad integrazione - che il robots.txt bloccante, blocca non solo un x-robots-tag, ma anche un 4**/3**.

ps: se vuoi completare il tuo blogpost mettici i log a dimostrazione che post robots.txt NON passa

-

@merlinox ha detto in Test SEO: rimozione tramite X-Robots-Tag di una pagina bloccata da robots.txt:

Che poi - non vorrei ricordare male - da qualche parte avevo letto un commento di qualcuno di Google in cui diceva che comunque gli x-robots-tag, anche se già presenti nell'header, venivano considerati in fase di analisi della pagina e non del protocollo (come potrebbe essere uno status code).

Alla fine, strettamente parlando, gli header HTTP comunque vengono serviti al client DOPO la richiesta. Fanno a tutti gli effetti parte del pacchetto di dati inviato via HTTP.

Ci sta che abbiano una pipeline dedicata per gli status code (sono funzionali all'efficienza di scansione, vedi ad es. il 301), mentre tutto il resto (X-Robots-Tag, ma non solo, ad esempio anche Unavailable-After, etc.) venga mandato normalmente al parser.

Comunque alla fine l'esperimento è stato più un esercizio di stile, dato che c'è scritto chiaro e tondo nella documentazione di Google:

https://developers.google.com/search/docs/advanced/robots/robots_meta_tag#combining

1 Risposta

-

@kal fatto comunque bene a farlo.

-

Grazie tante per la condivisione!

-

@kal ha detto in Test SEO: rimozione tramite X-Robots-Tag di una pagina bloccata da robots.txt:

Raccolgo volentieri feedback e osservazioni!

Ciao Martino,

Ho letto l'articolo e riletto la parte iniziale ed ecco il mio commento.Il Disallow nel robots.txt indica a Google di non leggere quella Url o sezione del sito. Questo blocca a monte l'accesso a qualunque url, immagine o similare ci sia nelle sezioni bloccate.

Resta il dubbio se Google rispetta il disallow nel file robots.txt? A quanto mi risulta si, infatti ho visto in passato pagine cancellate o messe in noindex che erano ancora nella cache di Google o trovabili su Google visto che il sito era stato messo completamente in disallow sul robots.txt. Questo perchè Google aveva memorizzato il sito ma non poteva più vedere gli aggiornamenti perchè bloccato.

Ora si potrebbe fare un test approfondito su diversi siti analizzando poi i log ma per mancanza di tempo non riesco e non trovo utile avere risposta a questo quesito.

Faccio un esempio pratico. Google ha in memoria il dominio connect.gt e le sue 3 url, UrlA, UrlB e UrlC. Decido di mettere nel file Robots.txt l'UrlC in disallow. Google leggerà UrlC per tempo X, dove il tempo X esiste fini a che Google non rilegge e aggiorna i parametri del file Robots.txt. Dopo il tempo X Google non saprà mai se l'UrlC esiste, è o non è in noindex, se cambia, se fa 301...

P.s.

Ora chiedo l'aiuto ai più esperti ma penso di aver capito. Dal tuo articolo sembra di capire che si parte dal presupposto che Google sia in grado di leggere tutto l'htaccess e quindi anche le istruzioni NOINDEX li indicati.P.p.s.

L'articolo "incriminato" porta nomi di professionisti Seo, di cui uno che scrive anche qui sul forum. Sarebbe interessante avere anche la loro opinione in merito.

1 Risposta

-

@sermatica ha detto in Test SEO: rimozione tramite X-Robots-Tag di una pagina bloccata da robots.txt:

Dal tuo articolo sembra di capire che si parte dal presupposto che Google sia in grado di leggere tutto l'htaccess e quindi anche le istruzioni NOINDEX li indicati.

Sì, anche se come ho scritto chiaramente e successivamente dimostrato, questa cosa non succede.

@sermatica ha detto in Test SEO: rimozione tramite X-Robots-Tag di una pagina bloccata da robots.txt:

L'articolo "incriminato" porta nomi di professionisti Seo, di cui uno che scrive anche qui sul forum. Sarebbe interessante avere anche la loro opinione in merito.

Sì, concordo!!

-

Precisiamo che Googlebot non legge alcun htaccess come il buon @kal spiega nel post.

Non vedo comunque perché dovrebbe essere cambiato un comportamento consolidato e indiscutibile

-

Google rispetta il robots.txt, provato testato assodato dichiarato.

Non ci sono dubbi, il resto è fuffa.Settimane fa presi un abbaglio, documentato qui https://connect.gt/topic/247086/google-che-non-rispetta-il-robots-txt/, ma in realtà era banalmente un classico problema di asincronia tra le date / ore nei report di Google.

Quando Google legge e recepisce il robots.txt, lo rispetta nel modo più assoluto.

ps: c'è ancora gente che non sa la differenza tra robots.txt e noindex e dice di fare SEO!

1 Risposta

-

@merlinox ha detto in Test SEO: rimozione tramite X-Robots-Tag di una pagina bloccata da robots.txt:

ps: c'è ancora gente che non sa la differenza tra robots.txt e noindex e dice di fare SEO!

Ebbene sì.

-

Ciao,

riesumo questa discussione con questo video e questo, sempre preso dal video, https://www.yelp.it/robots.txt.

-

Bello, interessantissima questa discussione. Bravo @kal per l'ottima esposizione e grazie @sermatica per il video.

Prendo spunto dalle ultime parole di Francesco Margherita per raccontarvi la mia esperienza personale.

Probabilmente sto sbagliando io qualcosa perché, in coincidenza di un aumento di Scansioni, sono aumentate notevolmente anche le pagine "indicizzate ma bloccate da robots". Nel mio caso si tratta di incroci multipli generati da filtri a faccette che storicamente ho sempre bloccato via robots... invece google ci è entrato alla grande, ignorando del tutto le regole di disallow (come nell'esempio di yelp) e adesso sto valutando di metterle in noIndex.

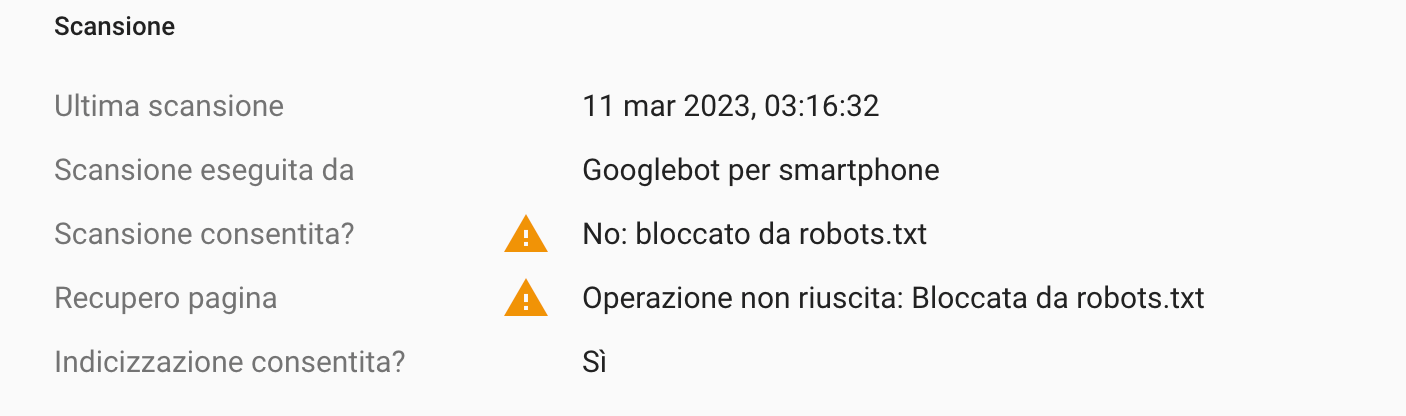

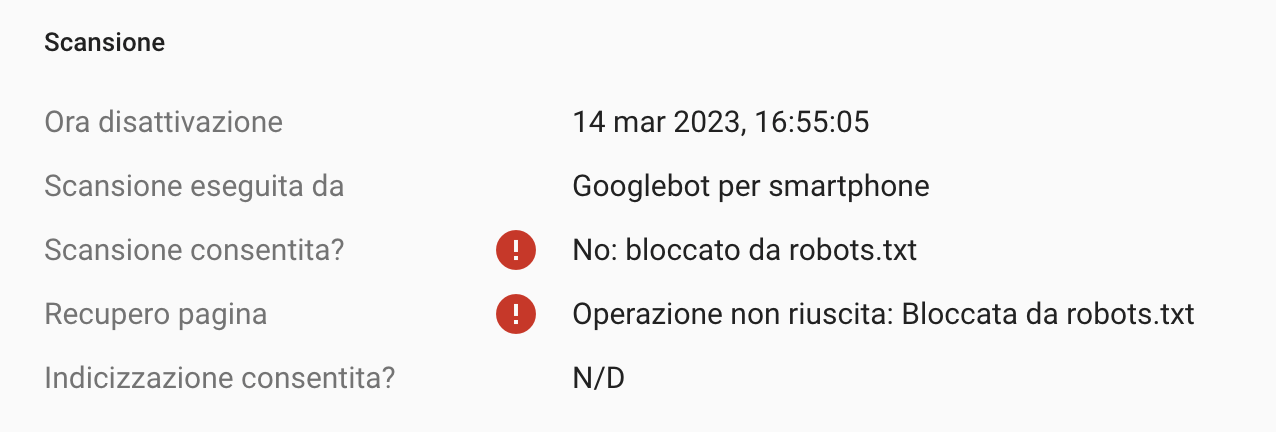

Confermo invece che nelle Serp questi risultati sono SENZA Title e DescriptionQuesta è una delle pagine che risulta indicizzata ma bloccata da robots. Come è possibile che "Scansione consentita = no" e "recupero pagina = bloccata da robots" e poi invece "indicizzazione consentita: SI"?!?!?

mentre questo è il test in tempo reale

1 Risposta

-

@kejsirio ha detto in Test SEO: rimozione tramite X-Robots-Tag di una pagina bloccata da robots.txt:

in coincidenza di un aumento di Scansioni, sono aumentate notevolmente anche le pagine "indicizzate ma bloccate da robots".

Può succedere. Se Googlebot innesca una fase di deep crawling possono aumentare anche quel tipo di errori.

Nel mio caso si tratta di incroci multipli generati da filtri a faccette che storicamente ho sempre bloccato via robots... invece google ci è entrato alla grande, ignorando del tutto le regole di disallow (come nell'esempio di yelp) e adesso sto valutando di metterle in noIndex.

Sono pagine con link esterni? Quelle pagine hanno impressioni su GSC?

1 Risposta

-

@kal se per link esterni intendi altri domini che puntano a quelle pagine, no (almeno che io sappia). Dall'applicazione invece sono raggiungibili da tutti gli utenti che usano i filtri a faccette. Forse è proprio questo il motivo per cui il Crawler ci è entrato fregandosene delle regole robots. Sto valutando anche di usare rel="nofollow" sui link, proprio per rafforzare il blocco.

Per fortuna non ci sono impression su GSC e nelle Serp ti confermo che questi risultati vengono spesso nascosti in "sono state omesse alcune voci molto simili", oltre a essere senza Title e Description

1 Risposta

-

@kejsirio ha detto in Test SEO: rimozione tramite X-Robots-Tag di una pagina bloccata da robots.txt:

Forse è proprio questo il motivo per cui il Crawler ci è entrato fregandosene delle regole robots.

Non ci è entrato. Controlla se vuoi nei log, non lo troverai. Ti posso rassicurare su questo!

@kejsirio ha detto in Test SEO: rimozione tramite X-Robots-Tag di una pagina bloccata da robots.txt:

Sto valutando anche di usare rel="nofollow" sui link, proprio per rafforzare il blocco.

Se fai così, neutralizzi il link che potrebbe aver portato Google a considerarle come indicizzate. Non è una cattiva idea, ma

@kejsirio ha detto in Test SEO: rimozione tramite X-Robots-Tag di una pagina bloccata da robots.txt:

Per fortuna non ci sono impression su GSC e nelle Serp ti confermo che questi risultati vengono spesso nascosti in "sono state omesse alcune voci molto simili", oltre a essere senza Title e Description

Si tratta di un classico non-problema SEO

Se Googlebot non le scansiona (e ci puoi scommettere che non lo fa) e non appaiono in SERP in modo indesiderato... allora non c'è bisogno di fare nulla!

Il fatto che quelle pagine appaiano rendicontate a quel modo su GSC è semplicemente la dimostrazione che tutto fila come dovrebbe.

1 Risposta

-

@kal grazie per le rassicurazioni, sei sempre gentile e preciso.

La mia preoccupazione è che veda un aumento di contenuti "poco utili" e mi possa penalizzare in qualche altro modo. Stiamo parlando di 900mila pagine "bloccate ma indicizzate" su un totale di 1,6Mln

1 Risposta

-

@kejsirio ha detto in Test SEO: rimozione tramite X-Robots-Tag di una pagina bloccata da robots.txt:

La mia preoccupazione è che veda un aumento di contenuti "poco utili" e mi possa penalizzare in qualche altro modo. Stiamo parlando di 900mila pagine "bloccate ma indicizzate" su un totale di 1,6Mln

È un bel numerone (normale, succede con la navigazione a faccette!), ma non ho notizia di casi in cui questa cosa abbia causato problemi. Anche perché come fa Google a sapere che quel contenuto è "poco utile" se prima non lo scansiona?

La direttiva robots è una direttiva tecnica, non ha nulla a che vedere con l'analisi dei siti web. Ci sono un milione di motivi legittimi per cui un webmaster debba voler bloccare Googlebot.

Stai bloccando l'accesso a Googlebot a delle pagine che effettivamente non vuoi che siano scansionate, Googlebot onora la direttiva, le pagine non finiscono in SERP e tutto è bene quel che finisce bene.

Considera fra parentesi che con il blocco robots.txt stai anche impedendo che quelle URL ricevano (e fluiscano) Pagerank e questo potrebbe o non potrebbe essere un problema, a seconda delle situazioni.

Infatti io di solito raccomando di impostare le URL della navigazione a faccette come:

- scansionabili

- con il rel canonical verso la pagina senza filtri

Il pro è che così passano e fluiscono il Pagerank. Il contro è che Googlebot consuma un po' delle risorse del server e questa cosa per siti molto grandi e complessi potrebbe impattare sul crawl budget (anche se un rel canonical ben piazzato di solito riduce al minimo le scansioni di queste pagine da parte di Googlebot).

Ti rimando a questa mia vecchia presentazione fatta al Serious Monkey nel 2019!

https://www.slideshare.net/MartinoMosna/domare-la-navigazione-a-faccette-per-ottimizzare-il-processo-di-scansione